Introduction à l’Informatique Affective

L’informatique affective est l’étude et le développement de systèmes et d’appareils ayant les capacités de reconnaître, d’exprimer, de synthétiser et de modéliser les émotions humaines. C’est un domaine de recherche interdisciplinaire couvrant les domaines de l’informatique, de la psychologie et des sciences cognitives qui consiste à étudier l’interaction entre technologie et sentiments.

Le domaine de l’informatique affective cherche à donner aux machines la capacité d’établir une communication dans les deux sens, à savoir pouvoir évaluer l’émotion d’un utilisateur et afficher une réaction émotionnelle, par exemple à l’aide d’avatars expressifs 1 2. L’informatique affective est donc directement liée au domaine de l’Interaction Homme Machine.

Historique de l’informatique affective

Les émotions remplissent de nombreuses fonctions chez l’humain, dont une fonction de communication lors d’interaction avec d’autres personnes. De nombreux domaines s’intéressent à l’émotion. La philosophie, l’histoire, l’ethnologie, l’éthologie, la neuroscience, la psychologie, ou encore les arts, pour lesquels l’émotion est une matière première.

Chez l’humain, l’empathie est la capacité de partager les émotions d’une autre personne, et de comprendre le point de vue de l’autre personne 3. Les tentatives de faire comprendre et réagir des systèmes d’intelligence artificielle à leur environnement relèvent des domaines de la cognitique. Les tentatives de mesurer objectivement des émotions chez l’humain prennent leurs racines dans des débuts de la psychologie expérimentale du XIXe siècle 4 .

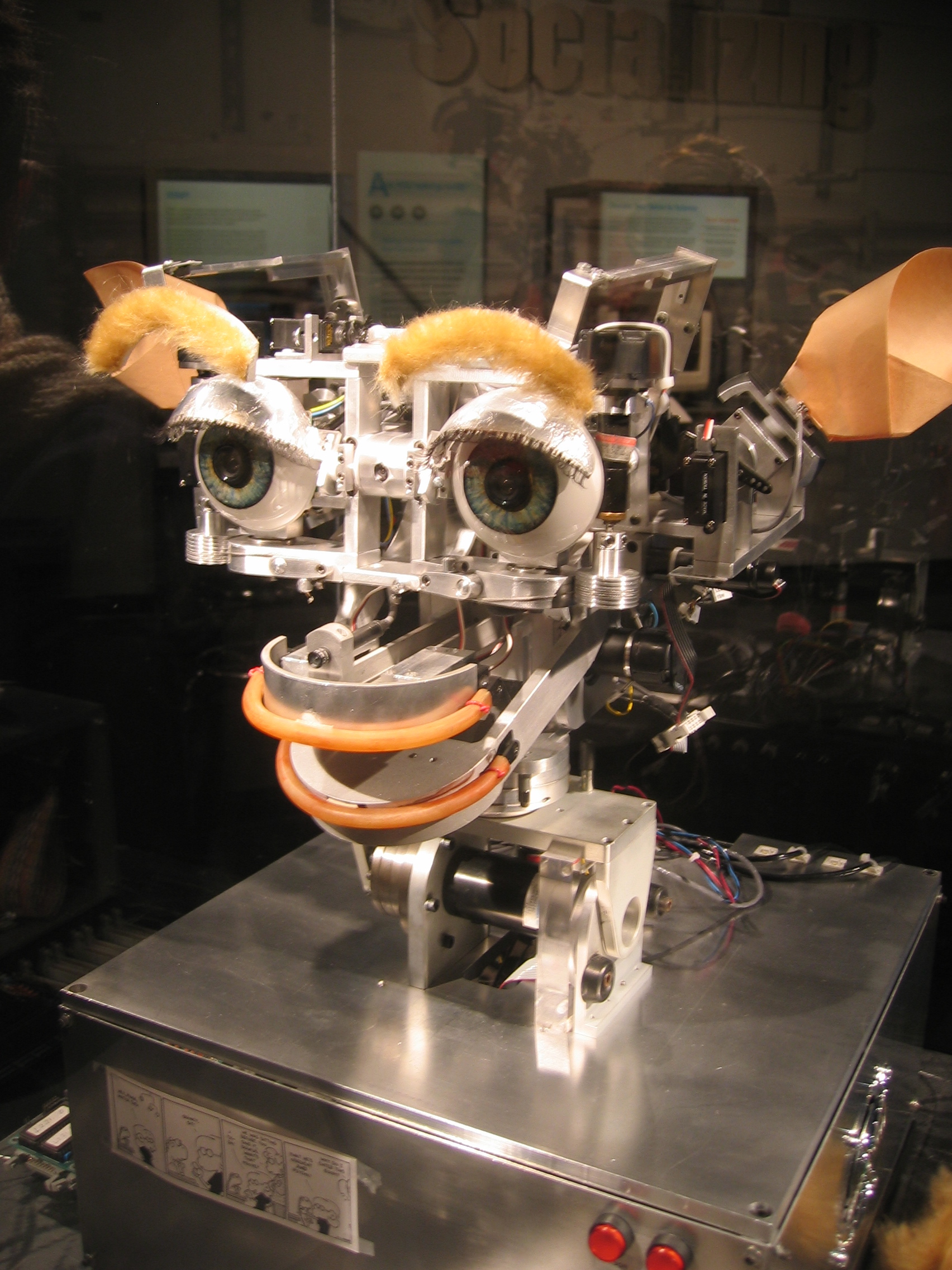

L’informatique s’est penchée sur l’émotion dans les années quatre-vingt-dix. En 1995, Rosalind Picard, chercheur informaticienne du Massachusetts Institut of Technology (MIT), publie un article qui pose les fondements de cette nouvelle discipline 5 . Elle met au point le premier robot social capable de traiter certaines informations sociales et affectives : Kismet.

Kismet

Kismet

Clippy

Clippy

Dans les années 2000, des prototypes d’ordinateur montrant de l’empathie, de la sympathie et des habiletés d’écoute active, sont mis au point et testés. L’objectif de ces prototypes est de permettre aux ordinateurs de gérer la frustration de leurs utilisateurs.

Les systèmes de reconnaissance ont au fil des années considéré les différents vecteurs de la communication émotionnelle, en commençant par le visage et la voix, pour ensuite s’intéresser à la gestuelle et enfin aux réactions physiologiques de l’émotion.

Émotions

Le terme « émotion » est un terme couramment utilisé, mais qu’il est difficile de définir avec précision. Intuitivement, nous sentons que l’émotion est un phénomène à la fois physique et physiologique. Mais

que caractérise une émotion ? La colère est sans conteste une émotion. Qu’en est-il de l’amour, du stress, de la nervosité ou de l’hostilité ?

La notion d’émotion est très familière, nous avons tous la capacité de la définir. Cependant, cette notion est plus complexe que ce qu’il paraît. Les définitions intuitives que nous pouvons proposer ne permettent pas de cerner le sujet de manière précise. De plus, de nombreuses ambiguïtés existent. En particulier, sur des termes tels que : affect, humeur ou sentiment. Les liens entre ces concepts ainsi que leurs limites ne sont pas évidents.

La culture joue également un rôle important dans la compréhension de l’émotion. Par exemple, l’« ijirashii » ( い じ ら し い ) est un terme japonais

définissant l’émotion ressentie lorsque l’on voit une personne louable franchir une difficulté.

Nous pouvons nous baser sur des études effectuées sur les définitions de Paul R. Kleinginna 6. Nous pouvons définir l’émotion comme une réponse à la fois corporelle (neurologique, physiologique …) et cognitive (sociale, mémoire, connaissances …), rapide, déclenchée par un évènement extérieur (évènement, objet) ou intérieur (souvenir), qui capte l’attention de la personne.

Les émotions ont un caractère universel et inné. Elles possèdent une fonction adaptative. Leurs manifestations les plus facilement observables sont les expressions faciales. Celles-ci sont universellement reconnues et jouent sans aucun doute un rôle important dans les interactions sociales. Ces expressions ont été étudiées en particulier par Izard (1982) et Ekman et Friesen (1977). Ekman et Friesen (1977) ont répertorié au niveau du visage toutes les contractions musculaires possibles ou unités d’action.

De nombreux travaux de recherche montrent que l’expression d’émotions des Agents Conversationnels Animés (ACA) permet d’améliorer l’interaction humain-machine 7. Cependant, pour garantir cet effet positif, les expressions des émotions doivent être appropriées aux événements et au contexte social de l’interaction. En effet, lorsque les expressions d’émotions de l’agent sont inappropriées, celui-ci est perçu plus négativement : moins crédible, moins agréable, etc. 8 . C’est en effet l’incompréhension par l’utilisateur des expressions des émotions de l’agent qui détériore l’interaction. Pour une communication émotionnelle compréhensible, il est donc important que les émotions de l’agent soient à la fois correctement exprimées et exprimées au moment opportun durant l’interaction. Pour ce faire, un ACA doit tout d’abord être doté d’un riche répertoire d’expressions. Les personnages virtuels existants utilisent souvent des expressions stéréotypées, très intenses, limitées au visage, leur conférant un aspect très caricatural et limitant leur capacité de communication émotionnelle à quelques émotions typiques (joie, colère, surprise, tristesse, dégoût et peur). Or, une reconnaissance des émotions est une condition nécessaire à une bonne compréhension de l’agent. Comme le montrent 9, certaines émotions comme l’embarras ou la fierté sont difficilement perceptibles à travers uniquement l’expression faciale.

Voix

La voix est un outil de communication, elle permet de se mettre en relation avec l’autre et de recevoir l’autre par sa voix. La voix est aussi un mode d’expression émotionnel, elle permet de transmettre et partager des informations et des émotions avec autrui.

L’étude de la voix est donc d’un intérêt particulier pour l’informatique affective : en effet, le comportement vocal et le ton employé jouent un rôle important dans l’interprétation par autrui dans un contexte donné notamment dans la détection du sarcasme et de l’ironie. Savoir écouter l’autre et dialoguer sur le même ton vocal ou son contraire est donc important pour la machine pour comprendre, et discerner les sous-entendus de son interlocuteur.

On distingue dans la voix 3 paramètres caractéristiques :

- L’intensité : L’air, expulsé des poumons, remonte dans le larynx, vers les cordes vocales. La pression (variable) de l’air exercée sous les cordes vocales va définir l’intensité de la voix (qui se mesure en décibels). 50 à 60 dB pour une conversation, jusqu’à 120 dB pour le chant lyrique.

- La fréquence: L’air traverse les cordes vocales, qui (commandées par le cerveau) s’ouvrent et se ferment. Le nombre d’ouvertures/fermetures par seconde correspond à la fréquence de la voix (ou tonalité ou hauteur), grave, aigüe ou médium, qui se mesure en hertz. Une voix médium : 100 Hz pour un homme, 200 Hz pour une femme.

- Le timbre : L’air circule alors dans les résonateurs (gorge, bouche, fosses nasales) et va prendre son timbre. Elle peut être nasillarde, chaude, sensuelle, métallique, blanche, etc.

Expression faciale

Les émotions ont un caractère universel et inné. Elles possèdent une fonction adaptative. Leurs manifestations les plus facilement observables sont les expressions faciales. Celles-ci sont universellement reconnues et jouent sans aucun doute un rôle important dans les interactions

sociales. Le visage est une source d’information importante. En dehors de la synchronisation entre la parole et l’animation du visage, les détails d’un visage jouent un rôle important pour transmettre une émotion 10.

Source https://imotions.com/blog/facial-action-coding-system/

Source https://imotions.com/blog/facial-action-coding-system/

On distingue principalement deux informations portées par le visage : l’identité et les expressions :

- L’identité est déterminée quasi intégralement par la forme et la position des os du crâne. Ces caractéristiques, uniques pour chaque individu permettent de le distinguer des autres.

- Les expressions sont déterminées par l’activation des muscles faciaux. De plus, certains processus émotionnels peuvent faire changer localement la couleur de la peau, en la colorant localement par un afflux sanguin plus important qu’à l’accoutumée.

Le visage humain se caractérise par une grande richesse expressive, dépassant de loin ce que l’on observe chez les autres primates 11, 12. Cette particularité, résultant de la différenciation de la musculature faciale humaine, est nettement mise en évidence dans les systèmes de codification qui ont vu le jour au cours des deux dernières décennies. Ainsi, le Facial Action Coding System (FACS), développé par 13, distingue 46 unités d’action qui correspondent chacune à un changement distinct d’apparence faciale. Ces 46 unités d’action peuvent être produites séparément ou sous forme de combinaisons pouvant comprendre jusqu’à une dizaine d’éléments. Les auteurs estiment que le nombre de combinaisons qui peuvent être produites par le visage humain atteindrait plusieurs milliers.

Les nombreuses expressions du visage seraient révélatrices de la nature de l’émotion, de son intensité, du degré de contrôle dont elle fait l’objet et de certaines particularités de la situation qui la provoque. Bien que les efforts visant à répertorier les expressions faciales des émotions en sont toujours à leur début, les données actuelles conduisent à penser que chacune des émotions fondamentales serait exprimée par plusieurs configurations distinctes. Des propositions très intéressantes à cet égard ont été faites par Friesen 13. Le répertoire que ces auteurs proposent contient près d’une centaine d’expressions.

Selon les théories psycho-évolutionnistes 14, 15, l’expressivité du visage est clairement mise à profit dans la communication émotionnelle et dans la régulation des interactions sociales. Les expressions du visage permettraient aux protagonistes impliqués dans une interaction de faire une appréciation de l’état émotionnel de l’autre et ce serait en partie sur cette appréciation que chaque protagoniste ajusterait son comportement. Ce système de régulation serait avantageux pour l’espèce parce qu’il favoriserait une réduction des conflits et une augmentation de la cohésion sociale 15.

Le comportement non verbal du visage accompagnant la parole, comme, par exemple, un léger hochement de tête ou un rapide soulèvement des sourcils, permet d’augmenter la compréhensibilité de la parole 16, et surtout de refléter l’émotion du locuteur. Même si des recherches ont confirmé que le comportement non verbal est lié fortement à la parole synchronisée 16.

Expression corporelle

La communication non verbale ou langage corporel désigne dans une conversation tout échange n’ayant pas recours à la parole. Elle ne repose pas sur les mots, mais sur les gestes, actions et réactions, les attitudes, les expressions faciales, dont les micro-expressions, ainsi que d’autres signaux,

conscients ou inconscients. Tout le corps fait passer un message aussi efficace que les mots que l’on prononce. De plus, les interlocuteurs réagissent inconsciemment aux messages non verbaux mutuels. La communication non verbale ajoute donc une dimension supplémentaire au message, parfois en contradiction avec celui-ci. C’est pourquoi il est intéressant, pour une communication homme- machine, que les machines puissent aisément identifier les expressions corporelles et réagir en conséquence.

De nombreux travaux ont montré l’importance du comportement non verbal dans la communication. Plus de la moitié des informations dans une interaction interpersonnelle sont en effet exprimées à travers les comportements non verbaux 17. Dans une interaction humain-machine, il est donc essentiel que les agents virtuels soient capables de produire des gestes expressifs communicatifs.

Toutefois, la reconnaissance des expressions corporelles a ses limites. En effet, bien qu’il existe des similitudes, les expressions corporelles n’ont pas toujours la même signification à travers les cultures.

De plus, le langage corporel n’est pas un langage appris explicitement, mais plutôt implicitement par intériorisation et imitation. Il n’y a donc pas d’interprétation clairement définie du langage corporel.

Indicateurs physiologiques

L’activité physiologique d’un individu est étroitement liée à ses états émotionnels. Le système nerveux autonome notamment les branches sympathiques et parasympathiques contrôle différentes réponses physiologiques qui peuvent être mesurées par des techniques simples. Par exemple, des modifications du rythme cardiaque, de la pression artérielle, de la température corporelle, des rythmes électro-encéphalograhiques, de la conductance cutanée, peuvent intervenir à la suite d’événements

émotionnellement chargés.

Empathie

Empathie vient du mot grec « empatheia », em signifie « dans » et pathos signifie « sentiment ». Cette notion réfère aux capacités que possède un individu pour comprendre (empathie cognitive), ressentir (empathie émotionnelle) ce qu’une autre personne vit et agir en conséquence (empathie compassionnelle), par la détection et l’interprétation des sentiments et pensées de cette tierce personne 18.

Empathie cognitive

Selon un vieil adage « Marchez un kilomètre à la place de quelqu’un d’autre et vous comprendrez », cela semble décrire l’empathie pour beaucoup, mais c’est en fait presque exclusivement une empathie cognitive. La cognition, c’est penser ou savoir. C’est le processus d’évaluation d’une situation et de

connaissance de ce qu’une autre personne traverse, car il est possible de saisir la situation grâce à nos propres connaissances. C’est une forme d’empathie, car elle consiste à projeter notre savoir sur un type de situation similaire et à reconnaître à l’autre personne que nous comprenons son expérience parce que nous avons, par exemple, vécu une situation similaire. Malheureusement, ce type de réponse empathique est souvent utilisé par les gens pour manipuler les autres plutôt que pour le rendre compatissant. Montrer ce type d’empathie peut être positif ou négatif.

Empathie émotionnelle

Le niveau suivant de la définition de l’empathie, l’empathie émotionnelle, comprend non seulement la connaissance de ce qui arrive à quelqu’un d’autre, mais aussi la capacité de ressentir ce qu’il ressent. Avoir une réaction émotionnelle lorsqu’on est mis au courant de la douleur émotionnelle d’un autre, cela provoque une contagion émotionnelle.En d’autres termes, notre réaction à leur sort provoque une réaction émotionnelle contagieuse. Les personnes le ressentent, selon des psychologues tels que Daniel Goleman dans son livre « Social Intelligence », en raison du système de neurones miroirs. Ce système permet aux humains et certains mammifères de refléter ce qu’ils voient ou constatent chez l’autre. Il peut s’agir de postures ou d’émotions.

Empathie compassionnelle

C’est une réponse plus profonde que simplement savoir ou ressentir ; c’est ce type d’empathie qui pousse une personne à agir à cause de ce que vit une autre personne. L’empathie compassionnelle correspond à ce que nous entendons par compassion : ressentir la douleur de quelqu’un et agir en conséquence. Comme la sympathie, elle consiste à ressentir la douleur et l’inquiétude pour quelqu’un, mais avec une action visant à atténuer le problème. Elle pousse les personnes à agir lorsqu’ils voient

une autre personne en détresse.

Reconnaissance d’émotions

La reconnaissance d’émotions est un domaine jeune, mais dont la maturité grandissante implique de nouveaux besoins en termes de modélisation et d’intégration dans des modèles existants. Elle consiste à associer une émotion à une image de visage, un son ou à des données physiologiques. Le but est donc de déterminer, d’après cette modalité l’état émotionnel interne de la personne.

Reconnaissance d’émotion par modalité vocale

La reconnaissance vocale est une technique informatique qui permet d’analyser la voix humaine captée au moyen d’un microphone pour la transcrire sous la forme d’un texte exploitable par une machine. De nos jours, l’apprentissage profond à la reconnaissance vocale permet d’atteindre des taux d’erreurs relativement faibles, 5,5% pour la reconnaissance vocale d’IBM, alors que l’humain à un taux d’erreurs de 5.1%.Toutefois, la reconnaissance vocale a ses limites. En effet, pouvant être facilement usurpée, elle ne peut pas servir de moyen d’authentification par exemple. Aussi, les différents accents au sein d’une langue peuvent poser problème à la compréhension.

Cependant ces techniques utilisées pour la reconnaissance vocale peuvent être appliquées à la compréhension d’émotions. C’est-à-dire se concentrer sur la manière dont une phrase est prononcée que sur son contenu.Shiqing Zhang dans 19 propose une nouvelle méthode de reconnaissance des émotions de la parole dans un signal de parole en utilisant Fuzzy Least Squares Support Vector Machines (FLSSVM) basé sur l’extraction de caractéristiques de prosodie et de qualité vocale à partir d’un discours émotionnel.

Reconnaissance d’expressions faciales

La reconnaissance faciale semble être la technologie biométrique la plus naturelle et la plus simple à mettre en pratique. En effet, les expressions faciales sont naturellement utilisées pour envoyer des messages émotionnels entre individus. C’est pourquoi il est intéressant, pour une communication homme-machine, que les machines puissent aisément reconnaître et comprendre les expressions du visage et réagir en conséquence.

Les logiciels de reconnaissance faciale sont capables d’identifier les individus selon la morphologie de leur visage à partir d’une image ou d’un capteur photo. L’efficacité de la reconnaissance faciale dépend de trois facteurs clés :

- La qualité de l’image ;

- L’algorithme d’identification ;

- La fiabilité de la base de données.

Ces mêmes techniques peuvent être appliqués à la reconnaissance des expressions faciales. Dans la littérature plusieurs techniques ont été proposées pour facilement reconnaitre les expressions : 20,21, 22, 23, 24, 25, 26, 27, 28 proposent une approche multimodale pour la reconnaissance des huit émotions. Leur approche intègre des informations provenant d’expressions faciales, mouvements du corps et gestes et discours. 29Reconnaissance d’émotions par les expressions corporellesDarwin 30 a été le premier à proposer plusieurs principes décrivant en détail comment le langage corporel et la posture sont associés aux émotions chez l’homme et les animaux. Bien que les recherches de Darwin sur l’analyse des émotions se sont concentrées sur le langage du corps et la posture 31, 32, 33, les systèmes de détection des émotions existants négligent l’importance de la posture du corps par rapport aux expressions faciales et à la reconnaissance vocale. Cette étude 34 suggère aussi que les informations véhiculées par les expressions corporelles n’ont pas été suffisamment explorées.

De plus, la posture corporelle peut fournir des informations qui parfois ne peuvent pas être transmises par canaux non verbaux conventionnels tels que les expressions faciales et la parole. Le plus grand avantage de la reconnaissance des émotions à partir des informations corporelles est que ceux-ci sont inconscients, non intentionnels et, par conséquent, non susceptibles à l’environnement comparé aux expressions faciales et à la parole. 35 , 36, 37, 38, dans leurs études de la tromperie, montrent qu’il est beaucoup plus facile de dissimuler la duperie par l’expression du visage que le canal de la posture du corps moins contrôlable. La posture du corps peut communiquer des catégories d’émotions discrètes et émotionnelles 35, 36. 39 et 40 proposent une approche en temps réel pour reconnaître automatiquement les émotions à partir des mouvements du corps.

Reconnaissance d’émotions par les indicateurs physiologiques

Il a été démontré que les changements physiologiques occupent une place importante lors d’expériences émotionnelles 41. L’émotion est un processus psychophysiologique, produit par l’activité du système limbique en réponse à un stimulus, ce qui conduit à l’activation du système somatosensoriel 42. En outre, différents changements physiologiques périphériques entraînent différentes émotions et un retour d’information corporel est nécessaire à l’émergence de l’émotion. 41.

Dans 43, 44, 45, les auteurs utilisent l’électro-cardiographie (ECG) pour classifier les émotions d’unepersonne donnée. Dans 46 l’électro-encéphalographie (EEG) a été utilisé. Dans 47, les auteurs utilisent plusieurs caractéristiques physiologiques telles que la température cutanée, la photopléthysmographie, l’activité électrodermique et l’électrocardiogramme.

1872.

«Unsupervised Learning in Reservoir Computing for EEG-based Emotion Recognition,» 2018.

-

G. Castellano, Movement expressivity analysis in affective computers : from recognition to expression of emotion, Genova: University of Genova, 2008 ↩︎

-

S. a. P. C. G. Pasquariello, «A simple facial animation engine,» chez In 6th Online World Conference on Soft Computing in Industrial Appications, 2001. ↩︎

-

M. W. Eysenck, Psychology, a student handbook, Hove: Psychology Press, 2000. ↩︎

-

J. T. e. T. Tan, «Affective Computing and Intelligent Interaction,» Computer Science, p. 981–995, 2005. ↩︎

-

R. Picard., Affective computing, Massachusetts: MIT press, 1997. ↩︎

-

J. a. A. M. K. Paul R. Kleinginna, Categorized List of Emotion Definitions, with Suggestions for a Consensual Definition, 1996. ↩︎

-

R. D. B. &. N. K. Russell, «Super-recognizers: People with extraordinary face recognition ability,» Psychonomic Bulletin & Review, p. 252, 2009. ↩︎

-

R. N. a. C. P. M. Ochs, «How a virtual agent should smile? Morphological and dynamic characteristics of virtual agent’s smiles,» chez International Conference on Intelligent Virtual Agents , 2010. ↩︎

-

M. O. E. B. K. P. Q. A. L. Y. D. J. H. Radoslaw Niewiadomski, La compréhension machine à travers l’expression non-verbale, Paris: Greta Team, 2011. ↩︎

-

N. T. C. C. J.-C. M. Mathieu Courgeon, «Postural Expressions of Action Tendency,» Nonverbal Behaviour, 2009. ↩︎

-

C. -. Skolnikoff, «Facial expression of emotion in nonhuman primates,» Nonverbal Behaviour, 1973. ↩︎

-

Redican, «Nonverbal communication in human interaction,» Nonverbal Behaviour, 1982. ↩︎

-

E. e. Friesen, «A New Pan-Cultural Facial Expression of Emotion,» Nonverbal Behaviour, pp. 159-168, 1978. ↩︎ ↩︎

-

Ekman, «Felt, false and miserable smiles,» Nonverbal Behaviour, pp. 238-252, 1982. ↩︎

-

Izard, Emotions, personality, and psychotherapy, New York: Plenum Press, 1991. ↩︎ ↩︎

-

J. A. J. D. E. C. T. K. V.-B. K. G. Munhall, Visual Prosody and Speech Intelligibility, British Columbia: Queen’s University, Kingston, Ontario, 2004. ↩︎ ↩︎

-

Mehrabian, Nonverbal concomitants of perceived and intended persuasiveness., Los Angeles, 1969. ↩︎

-

Y. &. L. C. Lussier, Rapport de recherche soumis aux Centres de traitement pour hommes à comportements violent, Québec: Université du Québec à Trois-Rivières, 2002. ↩︎

-

S. Zhan, «Speech emotion recognition based on Fuzzy least squares support vector machines,» chez 7th world congress on intelligent control and automation, Chongqing, 2008. ↩︎

-

Y. Tang, Deep learning using linear support vector machines, arXiv, 2013. ↩︎

-

K. B. a. G. W. T. T. Devries, «Multi-task learning of facial landmarks and expression,» Computer and Robot Vision, p. 98–103, 2014. ↩︎

-

P. L. C. C. L. a. X. T. Z. Zhang, «Learning social relation traits from face images,» chez International Conference on Computer Vision, 2015. ↩︎

-

D. T. J. Y. H. X. Y. L. a. D. T. Y. Guo, «Deep neural networks with relativity learning for facial expression recognition,» chez Multimedia & Expo Workshops (ICMEW), 2016. ↩︎

-

S.-Y. D. J. R. G. K. a. S.-Y. L. B.-K. Kim, «Fusing aligned and non-aligned face information for automatic affect recognition in the wild: A deep learning approach,» chez Conference on Computer Vision and Pattern Recognition Workshops, 2016. ↩︎

-

C. P. a. M. Kampel, «Facial expression recognition using convolutional neural networks: State of the art,» arXiv, 2016. ↩︎

-

M. A.-S. W. P. C. a. M. G. T. Connie, «Facial expression recognition using a hybrid cnn–sift aggregator,» International Work-shop on Multi-disciplinary Trends in Artificial Intelligence, p.139–149, 2017. ↩︎

-

G. K. L. &. C. G. Castellano, «Emotion Recognition through Multiple Modalities: Face, Body Gesture, Speech,» Computer Science, 2016. ↩︎

-

M. A.-S. W. P. C. a. M. G. Connie T., «Facial expression recognition using a hybrid cnn-sift aggregator,» chez International Workshop on multi-disciplinary trends in Artificial Intelligence, 2017. ↩︎

-

H. A. Simon, Model of a man social and rational, mathematical essays on rational human behaviour in society setting, New York: Wiley, 2004. ↩︎

-

C. Darwin, The Expression of the Emotions in Man and Animals, NY: Oxford University Press, 1872. ↩︎

-

C. Darwin, The Expression of the Emotions in Man and Animals, NY: Oxford University Press, ↩︎

-

M. Argyle, Bodily communication, London: Methuen, 1975. ↩︎

-

a. B. D. G. N. Hadjikhani, «Seeing fearful body expressions activates the fusiform cortex and amygdale,» Current Biology, pp. 2201-2205, 2003. ↩︎

-

Q. &. J. E. Liu, «Muscle memory,» The Journal of Physiology, p. 775–776, 2011. ↩︎

-

M. Coulson, «Attributing emotion to static body postures: Recognition accuracy, confusions, and viewpoint dependence,» Nonverbal Behaviour, 2004. ↩︎ ↩︎

-

E. K. D. Z. a. M. A. J. Montepare, «The use of body movements and gesture as cues to emotions in younger and older adults,» Nonverbal Behaviour, pp. 133-152, 1999. ↩︎ ↩︎

-

a. K. W. R. Walk, «Perception of the smile and other emotions of the body and face at different distances,» Psychonomic Soc, p. 510, 1988. ↩︎

-

E. e. Friesen, «Nonverbal behaviour in psychotherapy research,» Research in Psychotherapy, pp. 179-216, 1968. ↩︎

-

A. S. F. O. A. V. A. C. Stefano Piana, «Real-time Automatic Emotion Recognition from Body Gestures». ↩︎

-

S. D. S. K. A. &. J. R. Saha, «A study on emotion recognition from body gestures using Kinect sensor,» chez International Conference on Communication and Signal Processing, 2014. ↩︎

-

Rivière, A., and Godet, B., 2003, L’affective computing: rôle adaptatif des émotions dans l’interaction homme–machine. Report, Charles de Gaulle University, Lille, France. pp. 9–12, 33–38 ↩︎ ↩︎

-

Lalanne, C., 2005, La cognition: l’approche des Neurosciences Cognitives. Report, Département d’informatique, René Descartes University, Paris, France. pp. 26–28. ↩︎

-

J. W. W. C. a. C. H. Y. Hsu, «Automatic ECG-Based Emotion Recognition in Music Listening,» chez International Conference on Computational Intelligence and Natural Computing, Wuhan, 2009. ↩︎

-

Y. X. a. G. Liu, «A Method of Emotion Recognition Based on ECG Signal,» chez International Conference on Computational Intelligence and Natural Computing, Wuhan, 2009. ↩︎

-

L. G. a. C. J. C. Defu, «Toward Recognizing Two Emotion States from ECG Signals,» chez International Conference on Computational Intelligence and Natural Computing, Wuhan, 2009. ↩︎

-

B. A. J. S.-M. A. M. A. Unsupervised Learning in Reservoir ComputingRahma Fourati, ↩︎

-

E. J. S. K. C. H. a. J. S. B. Park, «Seven emotion recognition by means of particle swarm optimization on physiological signals: Seven emotion recognition,» chez International Conference on Networking, Sensing and Control, Beijing, 2012. ↩︎

Articles Similaires

Ubuntu 24.04 LTS - Une version qui fait débat entre déception et enthousiasme

Ubuntu 24.04 LTS, “Noble Numbat”, a récemment été déployée, apportant son lot de nouveautés et de changements. Cette version suscite à la fois de l’enthousiasme et de la déception au sein de la communauté des utilisateurs et des développeurs. Déception et colère face à la gestion des paquets DEB Plusieurs utilisateur d’Ubuntu ont exprimé leur déception et colère face à la décision de Canonical, la société mère d’ Ubuntu, de favoriser les paquets Snap au détriment des paquets DEB.

Lire la SuiteLe concours de beauté Miss AI : un cauchemar dystopique ou le futur de la beauté ?

Dans un monde où la technologie et la beauté fusionnent, le concours de beauté Miss AI fait son apparition. Ce concours, organisé par The World AI Creator Awards, récompense les créateurs d’images et d’influenceurs générés par intelligence artificielle (IA). Mais qu’est-ce que cela signifie pour les standards de beauté et les femmes ? Le concours Miss AI est ouvert aux créateurs d’images et d’influenceurs générés par IA qui souhaitent montrer leur charme et leur compétence technique.

Lire la SuiteLe gouvernement du Salvador prend un coup dur : les hackers divulguent le code source et les accès VPN du portefeuille bitcoin national Chivo !

Le programme bitcoin du gouvernement du Salvador, Chivo, a été victime d’une série d’attaques informatiques ces derniers jours. Les hackers ont déjà divulgué les données personnelles de plus de 5 millions de Salvadoriens. Maintenant, les mêmes pirates informatiques ont publié des extraits du code source et des informations d’accès VPN du portefeuille bitcoin national Chivo sur un forum de hacking en ligne, CiberInteligenciaSV. Ceci est un coup dur pour El Salvador, qui lutte pour être un pionnier dans l’adoption du bitcoin.

Lire la Suite